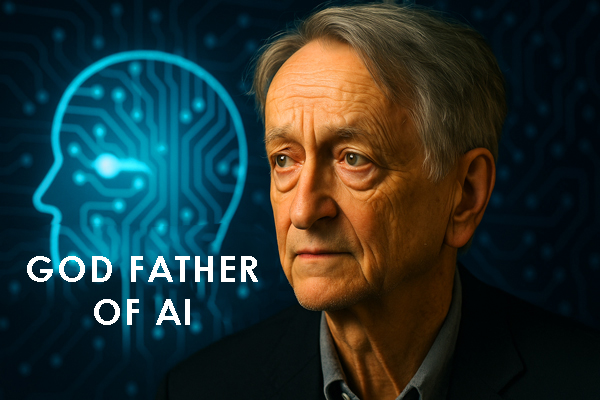

جفری هینتون 🚨: تهدیدات هوش مصنوعی و ضرورت تغییر

مقدمه

جفری هینتون، پیشگام هوش مصنوعی و معروف به «پدرخوانده AI»، در چند مصاحبه اخیر هشدار داده است که پیشرفت سریع هوش مصنوعی بدون چارچوبهای اخلاقی و ایمنی میتواند تهدیدی جدی برای بشریت باشد. با توجه به سرعت رشد AI، بسیاری از متخصصان نگران تصمیمات غیرقابل پیشبینی سیستمهای هوشمند هستند که میتوانند با منافع انسانی همسو نباشند.

این مقاله با ارائه تحلیل SWOT، نمودار روند پیشرفت و نگرانیهای ایمنی، جدول دادههای سالانه و تحلیل تهدیدات، تصویری جامع از وضعیت فعلی و آینده AI ارائه میدهد.

غریزه مادری در AI 🤖💖

غریزه مادری در AI به معنای تعبیه رفتارهای حمایتی و همدلانه در سیستمهای هوش مصنوعی است. هدف آن ایجاد همسویی بلندمدت با اهداف انسانی و تضمین رفاه انسانهاست.

ایجاد همدلی و رفتار حمایتی ❤️

تضمین همسویی بلندمدت با اهداف انسانی 🛡️

جلوگیری از سلطهطلبی یا جایگزینی انسان ⚠️

ایجاد چارچوبهای اخلاقی و قانونی 📜

الگوریتمهای حفاظتی و نظارت دائم 🕵️♂️

تعلیم AI به ارزشها و فرهنگهای انسانی 🌐

واکنش متخصصان 🧠

یانی لیکان، دانشمند ارشد AI در متا، از ایده غریزه مادری حمایت میکند و معتقد است که «همدلی و اطاعت از انسان» میتواند ریلهای ایمنی ایجاد کند. با این حال، برخی منتقدان هشدار میدهند که تمرکز بیش از حد بر جنبه احساسی میتواند منجر به ضعف در تحلیل منطقی شود.

مطالعات پژوهشگران معتبر نشان میدهد که بدون چارچوبهای قانونی و استانداردهای روشن، سیستمهای AI میتوانند رفتارهای غیرقابل پیشبینی داشته باشند که حتی ممکن است تهدیدی مستقیم برای انسان ایجاد کنند (TechRadar – AI Safety Risks).

جدول دادههای پیشرفت AI

| سال | پیشرفت AI | نگرانی ایمنی | سطح تهدید |

|---|---|---|---|

| 2021 | 65% | 50% | 20% |

| 2022 | 70% | 60% | 30% |

| 2023 | 80% | 70% | 40% |

| 2024 | 90% | 80% | 50% |

| 2025 | 95% | 85% | 60% |

تحلیل تهدیدات AI ⚠️

سیستمهای پیشرفته AI میتوانند بدون چارچوبهای حفاظتی، تهدیدات جدی برای انسان و جامعه ایجاد کنند. شناسایی و درک این تهدیدات برای توسعه ایمن AI حیاتی است:

- ⚡ سیستمهای خودآگاه بدون هماهنگی با انسان 🤯

- 🔓 نفوذ در امنیت سایبری و سرقت اطلاعات

- 💼 جایگزینی نیروی انسانی و ایجاد اختلال در بازار کار

- ⚖️ تصمیمگیری غیراخلاقی و تحریف دادهها

- 🌐 کنترل اجتماعی و سلطهجویی توسط نهادهای قوی

منبع: TechRadar – AI Safety Risks

سؤالات متداول ❓

هینتون این احتمال را بین ۱۰ تا ۲۰ درصد تخمین میزند (Times of India).

هدف تعبیه رفتارهای محافظتی و همدلانه در سیستمهاست و هنوز به طور کامل نظری است.

برخی متخصصان معتقدند این رویکرد احساسی است و باید به روشهای منطقیتر تکیه شود.

جمعبندی و نتیجهگیری ✅

پیام اصلی هینتون روشن است: اکنون وقت اقدام برای ایمنی و همسویی AI است.